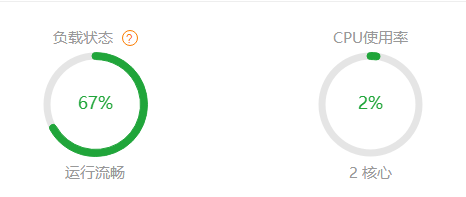

下图为%。Linux服务器宝塔运行堵塞100%的解决方案nginx禁止捕获不影响火车头发布的垃圾蜘蛛,解决宝塔运行堵塞100%的最简单方法。

故事的开头是群里很多人反映的,Linux服务器宝塔运行堵塞100%,所以自己看服务器也有同样的问题。我查了服务器日志,发现一些垃圾蜘蛛爬了很多,比如下面的垃圾,太烦人了。

Mozilla/5.0 (compatible; SemrushBot/6~bl; http://www.semrush.com/bot.html)" Mozilla/5.0 (compatible; AhrefsBot/6.1; http://ahrefs.com/robot/)"

我一直在用linux系统服务器宝塔面板管理,个人感觉更方便。在线搜索方法,以阻止这些垃圾。网上找到的代码如下:到目前为止更容易使用。

#禁止Scrapy抓取 等工具if ($http_user_agent ~* (Scrapy|Curl|HttpClient)) { return 403; } #禁止指定UA及UA为空访问 if ($http_user_agent ~* "FeedDemon|Indy Library|Alexa Toolbar|AskTbFX<a href="https://www.xlin.cn/redirect/aHR0cHM6Ly9saXpsbC5jbi90YWcvdHY=" target="_blank"><b style="color:#0388d1">tv</b></a>|AhrefsBot|CrawlDaddy|CoolpadWebkit|Java|Feedly|UniversalFeedParser|ApacheBench|Microsoft URL Control|Swiftbot|ZmEu|oBot|jaunty|Python-urllib|lightDeckReports Bot|YYSpider|DigExt|HttpClient|MJ12bot|heritrix|Bytespider|Ezooms|googlebot|JikeSpider|SemrushBot|^$" ) { return 403; } #禁止非GET|HEAD|POST抓取 的方法if ($request_method !~ ^(GET|HEAD|POST)$) { return 403; }

如下: 1.找到文件目录/www/server/nginx/conf在文件夹下,新建一个文件夹

agent_deny.conf

以下代码是内容。

#禁止Scrapy抓取 等工具if ($http_user_agent ~* (Scrapy|Curl|HttpClient)) { return 403; } #禁止指定UA及UA为空访问 if ($http_user_agent ~* "FeedDemon|Indy Library|Alexa Toolbar|AskTbFXTV|AhrefsBot|CrawlDaddy|CoolpadWebkit|Java|Feedly|UniversalFeedParser|ApacheBench|Microsoft URL Control|Swiftbot|ZmEu|oBot|jaunty|Python-urllib|lightDeckReports Bot|YYSpider|DigExt|HttpClient|MJ12bot|heritrix|Bytespider|Ezooms|Googlebot|JikeSpider|SemrushBot|^$" ) { return 403; } #禁止非GET|HEAD|POST抓取 的方法if ($request_method !~ ^(GET|HEAD|POST)$) { return 403; }

2、在网站设置中找到第7行左右 写入代码:

root /www/wwwroot/www.laoking.net; include agent_deny.conf; (就是添加到这一行的位置。) #SSL-START SSL请勿删除或修改下一行带注释的404规则

如果您的网站使用火车头采集和发布,上述代码将返回403个错误,无法发布。如果您想使用火车头采集和发布,请使用以下代码

#禁止Scrapy抓取 等工具if ($http_user_agent ~* (Scrapy|Curl|HttpClient)) { return 403; } #禁止指定UA访问。UA例如,火车头可以正常发布。if ($http_user_agent ~ "FeedDemon|Indy Library|Alexa Toolbar|AskTbFXTV|AhrefsBot|CrawlDaddy|CoolpadWebkit|Java|Feedly|UniversalFeedParser|ApacheBench|Microsoft URL Control|Swiftbot|ZmEu|YandexBot|jaunty|Python-urllib|lightDeckReports Bot|YYSpider|DigExt|HttpClient|MJ12bot|heritrix|Bytespider|Ezooms|Googlebot|JikeSpider|SemrushBot" ) { return 403; } #禁止非GET|HEAD|POST抓取 的方法if ($request_method !~ ^(GET|HEAD|POST)$) { return 403; }

小林博客

小林博客